Minimos Cuadrados 554328

This document was ed by and they confirmed that they have the permission to share it. If you are author or own the copyright of this book, please report to us by using this report form. Report 3i3n4

Overview 26281t

& View Minimos Cuadrados as PDF for free.

More details 6y5l6z

- Words: 1,103

- Pages: 6

Tarea 1. Enuncie y demuestre el teorema de la Aproximación de la Norma. El teorema de la Aproximación de la norma nos dice que la distancia entre 2 vectores (u) y (v) ϵ V es la norma de la diferencia de los dos vectores. ǁ𝑦 − ŷǁ = √< y − ŷ , y − ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y , y > − < y , ŷ > − < y , ŷ > + < ŷ , ŷ > = √ǁ𝑦ǁ2 − 2 < 𝑦 . ŷ > +ǁŷǁ2 Ahora veamos que sucede si 𝑦 − ŷ es perpendicular a la Imagen(A)

𝑦

𝑦−ŷ Au ŷ

Se puede notar que el vector ŷ es la proyección ortogonal del vector 𝑦 con respecto al subespacio 𝐴𝑢 para lograr que 𝑦 − ŷ sea perpendicular a la imagen de 𝐴𝑢. Si se aplica el teorema de Aproximación de la norma con ŷ = 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦 ǁ𝑦 − 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦ǁ = √< y − ŷ , y − ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y , y > − < ŷ , y > = √ǁ𝑦ǁ2 −< 𝑦 . ŷ >

Se puede comparar entonces: ǁ𝑦 − 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦ǁ ≤ ǁ𝑦 − ŷǁ Tarea 2. Justificar por qué se afirma que necesariamente 𝐴𝑇 𝑦 = 𝐴𝑇 𝐴ū Se requiere necesariamente esa igualdad para obtener la distancia mínima entre 𝑦 𝑒 ŷ para cualquier vector 𝑢 ∈ 𝑅𝑝 donde p es el número de parámetros tenga solución única. Además es necesario para obtener el vector ū el cuál es el vector que minimiza ǁ𝑦 − ŷǁ y se lo obtendría con ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 .

Tarea 3. Demostrar el teorema 1. La matriz (𝐴𝑇 𝐴)−1 si el rango de la matriz es igual a p donde p es el número de parámetros de la regresión lineal. Para este caso p=2. (Zurita Herrera, 2010) Para que el rango de la matriz sea p el Espacio Columna de la matriz tiene que ser igual a p, si la matriz A ya es una matriz nxp entonces sus columnas deben ser linealmente independientes. 1 𝑥1 1 𝑥2 𝐴 = 1 𝑥3 ⋮ ⋮ 1 𝑥𝑛

1 𝑥1 1 𝑥2 𝐸𝐶(𝐴) = 𝑔𝑒𝑛{1 𝑥3 } ⋮ ⋮ 1 𝑥𝑛 Aplicando conceptos de Dependencia lineal. 1 𝑥1 1 𝑥2 𝛼1 1 + 𝛼2 𝑥3 = 0 ⋮ ⋮ (𝑥𝑛 ) (1) Para cada Xi le corresponde un Yi entonces cada uno tendría una ecuación de la recta con diferentes vectores directrices. 𝑥1 = 𝑥0 + 𝑎1 𝑡 ; 𝑦1 = 𝑦0 + 𝑏1 𝑡 𝑥2 = 𝑥02 + 𝑎2 𝑡 ; 𝑦2 = 𝑦02 + 𝑏2 𝑡 𝑥3 = 𝑥03 + 𝑎3 𝑡 ; 𝑦3 = 𝑦03 + 𝑏2 𝑡 𝑥𝑛 = 𝑥0𝑛 + 𝑎𝑛 𝑡 ; 𝑦𝑛 = 𝑦0𝑛 + 𝑏𝑛 𝑡 Si son puntos colineales entonces el vector directriz (a, b) es el mismo para todos y los puntos (X0, Y0) también. 𝑥𝑖 = 𝑥0 + 𝑎𝑡 ; 𝑦𝑖 = 𝑦0 + 𝑏𝑡

Con lo que la ecuación de Independencia lineal seria: 𝑥0 + 𝑎𝑡 1 1 𝑥0 + 𝑎𝑡 𝛼1 1 + 𝛼2 𝑥0 + 𝑎𝑡 = 0 ⋮ ⋮ (1) (𝑥0 + 𝑎𝑡) −1

Entonces si 𝛼2 = 𝑥0+𝑎𝑡 𝑦 𝛼1 = 1 . El sistema se cumpliría, pero entonces como los alphas son diferentes de cero, no es Linealmente Independiente y el rango(A) sería menor a p. Por otro lado si no son puntos colineales entonces los alphas serían iguales a cero, el rango de la matriz seria p y concluiríamos que la matriz es invertible. Queda demostrado entonces que si los puntos no son colineales entonces, la matriz (𝐴𝑇 𝐴)−1 es invertible si los n puntos de datos (Xi, Yi) no son puntos colineales.

Tarea 4. Deducir la formulación para la regresión cuadrática, cuando se quiere relacionar dos secuencias de mediciones x e y mediante la expresión 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 . ¿Qué forma tienen en este caso las matrices A y u en la ecuación 𝑦ˆ = 𝐴𝑢? ¿Cuál es la expresión para el vector u que minimiza la distancia entre 𝑦 𝑒 𝑦ˆ ? 𝑥12 𝑥22 𝑥32 ⋮ 𝑥𝑛2 )

1 𝑥1 1 𝑥2 𝐴 = 1 𝑥3 ⋮ ⋮ (1 𝑥𝑛 𝑐 𝑏 𝑢=( ) 𝑎 𝑦1 1 1 𝑦2 En donde la formulación seria 𝑦3 = 1 ⋮ ⋮ (𝑦𝑛) (1

𝑥1 𝑥2 𝑥3 ⋮ 𝑥𝑛

𝑥12 𝑐 𝑥22 2 (𝑏 ) 𝑥3 𝑎 ⋮ 𝑥𝑛2 )

Para calcular el vector u podríamos usar las formas matriciales 𝑦 = 𝐴𝐮 Donde y es la matriz de observaciones, A es la matriz de diseño y u es el vector de parámetros. 𝐴𝑇 𝑦 = 𝐴𝑇 𝐴ū (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 = (𝐴𝑇 𝐴)−1 s𝐴𝑇 𝐴ū ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦

(Zurita Herrera, 2010)

Tarea 5. Rendimiento: 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 Haciendo en forma matricial los datos observados. 𝑦 = 𝐴𝐮

7.57 1 11.83 1 10.78 = 1 1 12.05 1 12.00 ( 9.96 ) (1

0 10 20 30 40 80

0 100 𝑐 400 (𝑏 ) 900 𝑎 1600 6400)

Para obtener el vector u tendremos que usar la fórmula que se dedujo en el ejercicio anterior ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 Ahora solo toca Multiplicar matrices. Para este proceso se utilizara un software en internet. (Matrix Calculator, s.f.) (𝐴𝑇 𝐴) =

(𝐴𝑇 𝐴)−1 =

(𝐴𝑇 𝐴)−1 𝐴𝑇 =

Finalmente

8.525 ū = ( 0.171 ) −0.002 La funcion de rendimiento es: 𝑦𝑖 = 8.525 + 0.171𝑥𝑖 − 0.002𝑥𝑖 2

Estatura: 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 Haciendo en forma matricial los datos observados. 𝑦 = 𝐴𝐮

99.5 1 112.5 1 112.75 = 1 1 114.25 1 106.75 (109.75) (1

0 0 10 100 𝑐 20 400 (𝑏) 30 900 𝑎 40 1600 80 6400 )

Como la matriz de diseño no cambia, el proceso es el mismo. (𝐴𝑇 𝐴)−1 𝐴𝑇 =

104.079 ū = ( 0.387 ) −0.004 La funcion de estatura es: 𝑦𝑖 = 104.079 + 0.387𝑥𝑖 − 0.004𝑥𝑖 2

Bibliografía Matrix Calculator. (s.f.). Obtenido de https://matrixcalc.org/es/ Zurita Herrera, G. (2010). Probabilidad y Estadistica. Guayaquil.

𝑦

𝑦−ŷ Au ŷ

Se puede notar que el vector ŷ es la proyección ortogonal del vector 𝑦 con respecto al subespacio 𝐴𝑢 para lograr que 𝑦 − ŷ sea perpendicular a la imagen de 𝐴𝑢. Si se aplica el teorema de Aproximación de la norma con ŷ = 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦 ǁ𝑦 − 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦ǁ = √< y − ŷ , y − ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y − ŷ , y > − < y − ŷ , ŷ > = √< y , y > − < ŷ , y > = √ǁ𝑦ǁ2 −< 𝑦 . ŷ >

Se puede comparar entonces: ǁ𝑦 − 𝑝𝑟𝑜𝑦𝐴𝑢 𝑦ǁ ≤ ǁ𝑦 − ŷǁ Tarea 2. Justificar por qué se afirma que necesariamente 𝐴𝑇 𝑦 = 𝐴𝑇 𝐴ū Se requiere necesariamente esa igualdad para obtener la distancia mínima entre 𝑦 𝑒 ŷ para cualquier vector 𝑢 ∈ 𝑅𝑝 donde p es el número de parámetros tenga solución única. Además es necesario para obtener el vector ū el cuál es el vector que minimiza ǁ𝑦 − ŷǁ y se lo obtendría con ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 .

Tarea 3. Demostrar el teorema 1. La matriz (𝐴𝑇 𝐴)−1 si el rango de la matriz es igual a p donde p es el número de parámetros de la regresión lineal. Para este caso p=2. (Zurita Herrera, 2010) Para que el rango de la matriz sea p el Espacio Columna de la matriz tiene que ser igual a p, si la matriz A ya es una matriz nxp entonces sus columnas deben ser linealmente independientes. 1 𝑥1 1 𝑥2 𝐴 = 1 𝑥3 ⋮ ⋮ 1 𝑥𝑛

1 𝑥1 1 𝑥2 𝐸𝐶(𝐴) = 𝑔𝑒𝑛{1 𝑥3 } ⋮ ⋮ 1 𝑥𝑛 Aplicando conceptos de Dependencia lineal. 1 𝑥1 1 𝑥2 𝛼1 1 + 𝛼2 𝑥3 = 0 ⋮ ⋮ (𝑥𝑛 ) (1) Para cada Xi le corresponde un Yi entonces cada uno tendría una ecuación de la recta con diferentes vectores directrices. 𝑥1 = 𝑥0 + 𝑎1 𝑡 ; 𝑦1 = 𝑦0 + 𝑏1 𝑡 𝑥2 = 𝑥02 + 𝑎2 𝑡 ; 𝑦2 = 𝑦02 + 𝑏2 𝑡 𝑥3 = 𝑥03 + 𝑎3 𝑡 ; 𝑦3 = 𝑦03 + 𝑏2 𝑡 𝑥𝑛 = 𝑥0𝑛 + 𝑎𝑛 𝑡 ; 𝑦𝑛 = 𝑦0𝑛 + 𝑏𝑛 𝑡 Si son puntos colineales entonces el vector directriz (a, b) es el mismo para todos y los puntos (X0, Y0) también. 𝑥𝑖 = 𝑥0 + 𝑎𝑡 ; 𝑦𝑖 = 𝑦0 + 𝑏𝑡

Con lo que la ecuación de Independencia lineal seria: 𝑥0 + 𝑎𝑡 1 1 𝑥0 + 𝑎𝑡 𝛼1 1 + 𝛼2 𝑥0 + 𝑎𝑡 = 0 ⋮ ⋮ (1) (𝑥0 + 𝑎𝑡) −1

Entonces si 𝛼2 = 𝑥0+𝑎𝑡 𝑦 𝛼1 = 1 . El sistema se cumpliría, pero entonces como los alphas son diferentes de cero, no es Linealmente Independiente y el rango(A) sería menor a p. Por otro lado si no son puntos colineales entonces los alphas serían iguales a cero, el rango de la matriz seria p y concluiríamos que la matriz es invertible. Queda demostrado entonces que si los puntos no son colineales entonces, la matriz (𝐴𝑇 𝐴)−1 es invertible si los n puntos de datos (Xi, Yi) no son puntos colineales.

Tarea 4. Deducir la formulación para la regresión cuadrática, cuando se quiere relacionar dos secuencias de mediciones x e y mediante la expresión 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 . ¿Qué forma tienen en este caso las matrices A y u en la ecuación 𝑦ˆ = 𝐴𝑢? ¿Cuál es la expresión para el vector u que minimiza la distancia entre 𝑦 𝑒 𝑦ˆ ? 𝑥12 𝑥22 𝑥32 ⋮ 𝑥𝑛2 )

1 𝑥1 1 𝑥2 𝐴 = 1 𝑥3 ⋮ ⋮ (1 𝑥𝑛 𝑐 𝑏 𝑢=( ) 𝑎 𝑦1 1 1 𝑦2 En donde la formulación seria 𝑦3 = 1 ⋮ ⋮ (𝑦𝑛) (1

𝑥1 𝑥2 𝑥3 ⋮ 𝑥𝑛

𝑥12 𝑐 𝑥22 2 (𝑏 ) 𝑥3 𝑎 ⋮ 𝑥𝑛2 )

Para calcular el vector u podríamos usar las formas matriciales 𝑦 = 𝐴𝐮 Donde y es la matriz de observaciones, A es la matriz de diseño y u es el vector de parámetros. 𝐴𝑇 𝑦 = 𝐴𝑇 𝐴ū (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 = (𝐴𝑇 𝐴)−1 s𝐴𝑇 𝐴ū ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦

(Zurita Herrera, 2010)

Tarea 5. Rendimiento: 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 Haciendo en forma matricial los datos observados. 𝑦 = 𝐴𝐮

7.57 1 11.83 1 10.78 = 1 1 12.05 1 12.00 ( 9.96 ) (1

0 10 20 30 40 80

0 100 𝑐 400 (𝑏 ) 900 𝑎 1600 6400)

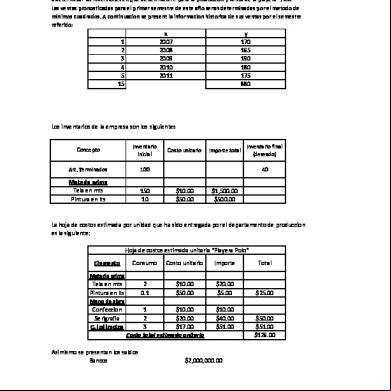

Para obtener el vector u tendremos que usar la fórmula que se dedujo en el ejercicio anterior ū = (𝐴𝑇 𝐴)−1 𝐴𝑇 𝑦 Ahora solo toca Multiplicar matrices. Para este proceso se utilizara un software en internet. (Matrix Calculator, s.f.) (𝐴𝑇 𝐴) =

(𝐴𝑇 𝐴)−1 =

(𝐴𝑇 𝐴)−1 𝐴𝑇 =

Finalmente

8.525 ū = ( 0.171 ) −0.002 La funcion de rendimiento es: 𝑦𝑖 = 8.525 + 0.171𝑥𝑖 − 0.002𝑥𝑖 2

Estatura: 𝑦𝑖 = 𝑐 + 𝑏𝑥𝑖 + 𝑎𝑥𝑖 2 Haciendo en forma matricial los datos observados. 𝑦 = 𝐴𝐮

99.5 1 112.5 1 112.75 = 1 1 114.25 1 106.75 (109.75) (1

0 0 10 100 𝑐 20 400 (𝑏) 30 900 𝑎 40 1600 80 6400 )

Como la matriz de diseño no cambia, el proceso es el mismo. (𝐴𝑇 𝐴)−1 𝐴𝑇 =

104.079 ū = ( 0.387 ) −0.004 La funcion de estatura es: 𝑦𝑖 = 104.079 + 0.387𝑥𝑖 − 0.004𝑥𝑖 2

Bibliografía Matrix Calculator. (s.f.). Obtenido de https://matrixcalc.org/es/ Zurita Herrera, G. (2010). Probabilidad y Estadistica. Guayaquil.